ChatGPT y anuncios a medida: OpenAI afronta su mayor pulso regulatorio

OpenAI ha anunciado que comenzará a insertar anuncios en ChatGPT antes de que termine enero de 2026. Inicialmente solo afectará a los usuarios estadounidenses con cuentas gratuitas o la nueva suscripción Go, mientras que los clientes de pago superior seguirán disfrutando de una experiencia sin publicidad. Es una decisión que la empresa describió como necesaria para sostener la viabilidad económica de un servicio que consume recursos computacionales cada vez más onerosos.

Lo que resulta más interesante no es el hecho en sí. Las plataformas digitales históricamente monetizan a través de la publicidad. Ya lo hicieron antes Google, Facebook o TikTok. Lo que importa es cómo OpenAI intenta hacerlo y, sobre todo, en qué momento lo intenta hacer. Porque la regulación europea está madurando justamente ahora, y esa regulación no está de acuerdo con los supuestos sobre los que OpenAI está construyendo su modelo.

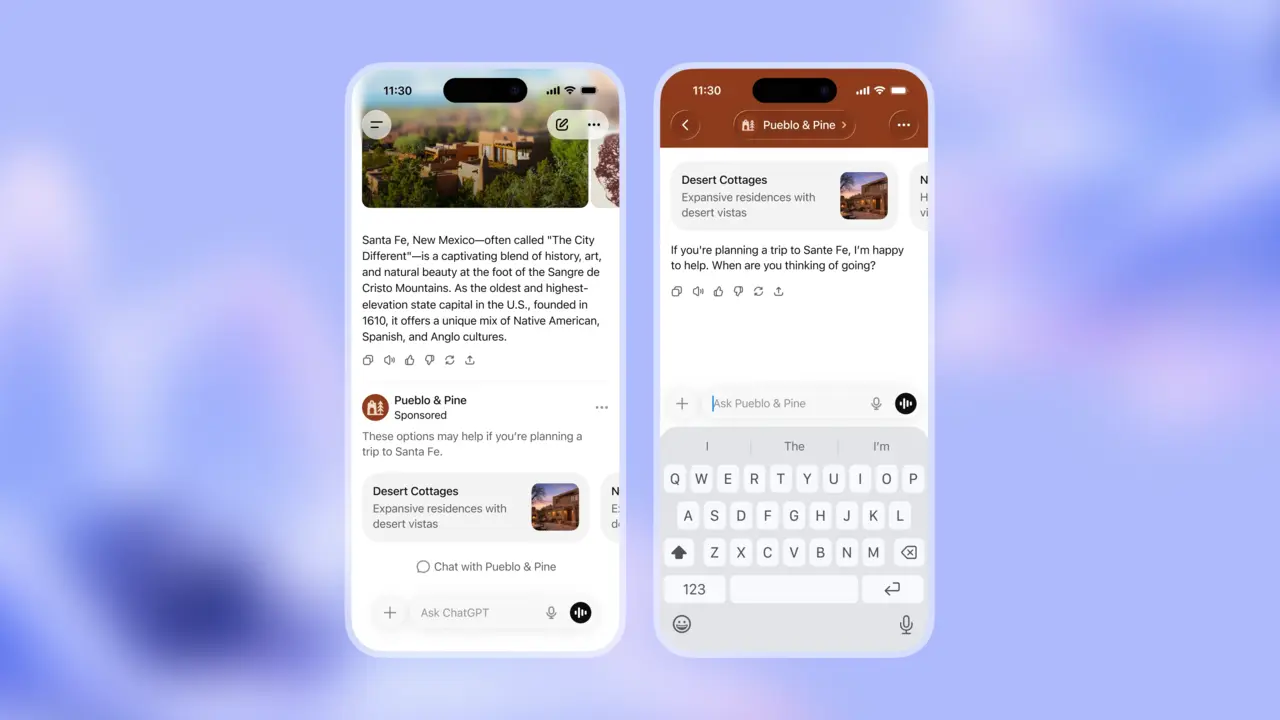

La compañía no niega que la publicidad será personalizada. Afirma que será "más útil y relevante que cualquier otro tipo de anuncio". Y en eso tiene razón desde una perspectiva técnica. ChatGPT tiene una ventaja competitiva clara frente a Facebook o Google para conseguir datos de comportamiento: acceso directo a conversaciones que revelan necesidades, temores, dudas y preferencias en contextos muy íntimos. Cuando busco un hotel en Google, la empresa sabe que busco hoteles. Eso es información superficial. Pero cuando le pregunto a ChatGPT cómo financiar una operación médica o cómo cambiar de carrera, la IA aprende sobre mí de formas que ni yo mismo he articulado conscientemente. Eso es información profunda. Y vulnerabilidad.

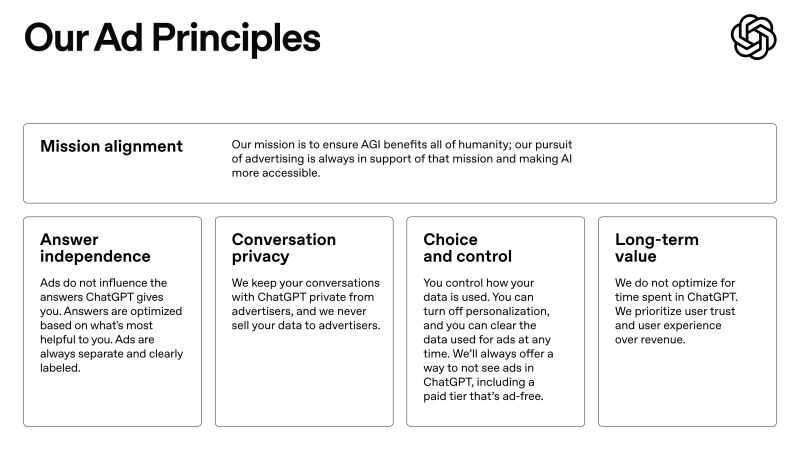

OpenAI ha intentado calmar las aguas con una serie de compromisos: afirma que los anuncios no influirán en las respuestas del modelo, las conversaciones no se venderán a anunciantes, no habrá publicidad en temas sensibles como salud o política, y el usuario podrá desactivar la personalización de anuncios. Son promesas razonables. Pero, ¿son suficientes desde el punto de vista jurídico?

El Tribunal de Justicia de la Unión Europea sentenció hace poco que Meta Platforms no puede utilizar indefinidamente datos personales recopilados fuera de su plataforma para anuncios dirigidos, incluso cuando tenga el consentimiento general del usuario. La publicidad segmentada exige bases jurídicas mucho más restrictivas que el consentimiento tácito implícito en los términos de servicio. Es necesario un consentimiento granular, específico e informado para cada fase del tratamiento de datos. OpenAI, al implementar anuncios personalizados, necesita procesar datos sobre el usuario. Esos datos incluyen el contenido de las conversaciones, patrones de interacción, horarios de uso, temas de interés y preferencias inferidas.

Y son estas inferencias, estas deducciones al más puro Sherlock Holmes, lo que me inquieta. La IA no solo conoce lo que le digo explícitamente. Calcula cosas sobre mí que ni yo sé. La Junta Europea de Protección de Datos ha establecido que estas inferencias son información personal protegida por el RGPD, incluso cuando no las proporciono directamente. Es decir, el sistema no necesita que yo declare "tengo ansiedad" para procesar datos sobre mi estado emocional. El algoritmo puede inferirlo de mis preguntas, mis patrones de búsqueda, mis horarios de consulta.

OpenAI admite en su política de privacidad que el sistema está entrenado para mejorar el modelo usando conversaciones de usuarios gratuitos, a menos que desactiven específicamente esa opción. El tratamiento de datos es la norma por defecto. La protección es la excepción. Esto colisiona con el principio de "privacidad por defecto" establecido en el artículo 25 del RGPD, que exige que los tratamientos de datos más restrictivos sean la configuración estándar, no la alternativa.

Luego está la cuestión del "privacy by design". La privacidad integrada desde la concepción del servicio. Cuando una plataforma se arquitectura fundamentalmente para recopilar conversaciones completas con el fin de entrenar modelos y personalizar anuncios, no es posible retroactivamente "hacer privada" una arquitectura intrínsecamente recolectora. La Agencia Española de Protección de Datos y el Garante italiano han sancionado con severidad a empresas que ignoraron estos principios. Cinco millones de euros al chatbot Replika por deficiencias en verificación de edad, minimización de datos y falta de transparencia. El caso es relevante porque Replika, como ChatGPT, recopilaba conversaciones intimas. El regulador italiano concluyó que los términos de servicio no son suficientes y se necesita un diseño técnico que proteja.

El Reglamento de Inteligencia Artificial entrará en vigencia completa el 2 de agosto de 2026. Exactamente el mismo mes en que OpenAI proyecta intensificar los anuncios. El artículo 26 del RIA impone lo que podría llamarse "transparencia radical": por cada anuncio, el sistema debe informar en tiempo real que es publicidad, quién lo presenta, quién lo paga, y cuáles son los parámetros de segmentación y cómo modificarlos. No es suficiente una etiqueta que diga "patrocinado". Tiene que explicar el mecanismo de la decisión.

¿Puede ChatGPT cumplir con esto? Técnicamente, probablemente sí. Pero ¿lo hará voluntariamente?

Hay una cuestión que trasciende lo jurídico. La publicidad personalizada ultradirigida que detecta vulnerabilidades emocionales puede convertirse en una herramienta de manipulación sofisticada. Por ejemplo, un usuario que busca ayuda psicológica puede ser segmentado para anuncios de terapeutas de dudosa calidad. El RGPD y el RIA prohíben explícitamente publicidad basada en datos sobre salud mental o estado emocional.

ChatGPT tiene información sobre estas fragilidades que ni el usuario ha compartido conscientemente con nadie. Eso crea una asimetría de conocimiento: la máquina sabe más sobre mis vulnerabilidades de lo que yo mismo sé. Y esa información es moneda de cambio en el mercado publicitario.

OpenAI dice que necesita monetizar porque la IA es cara. Es cierto. Y también es cierto que los códigos y regulaciones existen porque la innovación y la lógica empresarial no siempre priorizan la protección del ser humano. En los próximos meses veremos si OpenAI diseña un modelo de publicidad compatible con lo que la regulación europea exige. Si no lo consigue, se enfrenta a riesgos legales.

Porque lo que está en juego no es solo ChatGPT. Es si una arquitectura diseñada para consumir conversaciones humanas puede protegerlas simultáneamente. La respuesta que OpenAI dé a esa pregunta probablemente defina cómo construiremos la IA en Europa durante la próxima década.