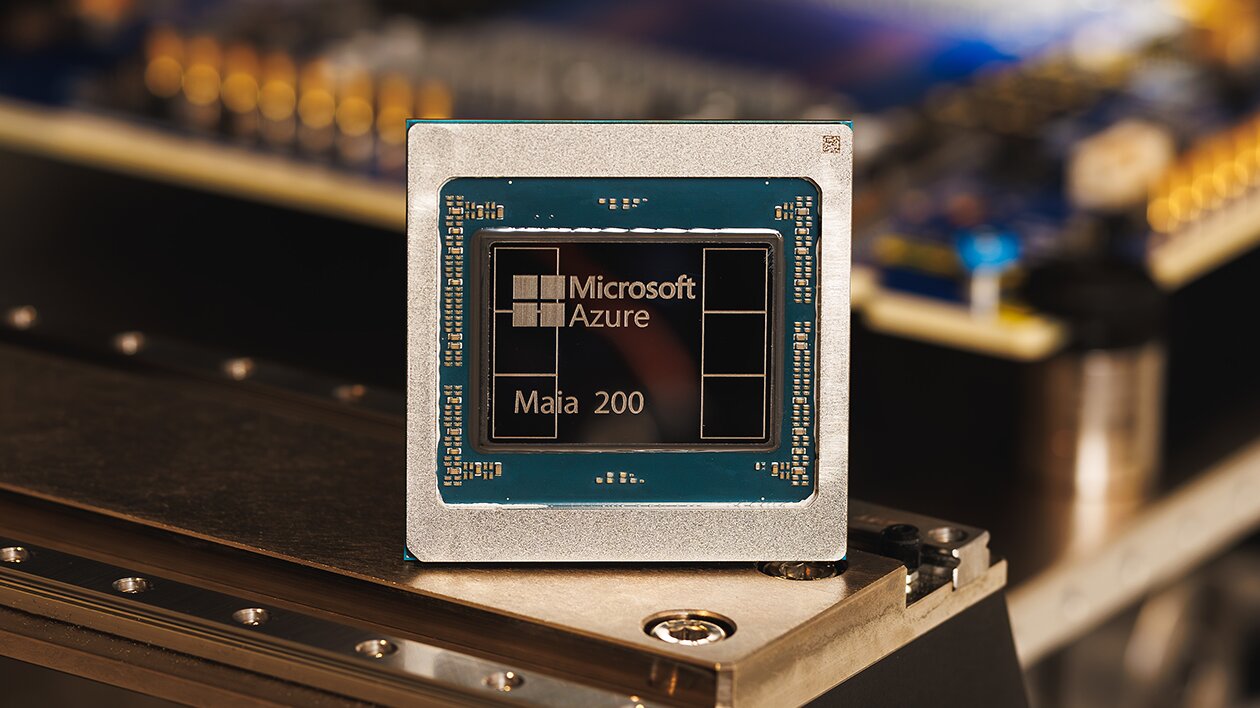

Microsoft presenta el chip Maia 200 para reforzar su potencia en IA

Microsoft ha dado un paso clave en la carrera tecnológica al presentar Maia 200, su nuevo acelerador de inferencia para inteligencia artificial, diseñado para mejorar el rendimiento y reducir los costes de ejecución de modelos avanzados en la nube de Azure. Fabricado con tecnología de 3 nanómetros y más de 140.000 millones de transistores, el chip refuerza la estrategia del gigante estadounidense para competir directamente con Nvidia y consolidar su liderazgo en servicios de IA empresarial.

Microsoft Corporation anunció este lunes el lanzamiento de Microsoft Maia 200, un chip de nueva generación específicamente diseñado para acelerar la inferenciación de modelos de inteligencia artificial, es decir, la fase en la que los modelos ya entrenados procesan y generan respuestas en tiempo real.

El anuncio se produce en un contexto de competencia feroz entre los grandes gigantes tecnológicos por controlar la infraestructura clave que sustenta la expansión de la IA generativa, un mercado que mueve miles de millones de dólares y que se ha convertido en uno de los pilares estratégicos del crecimiento del sector tecnológico.

para acelerar la inferenciación de modelos de inteligencia artificial

Tecnología puntera: 3 nanómetros y 140.000 millones de transistores

Según informó la compañía, el chip Maia 200 ha sido fabricado por TSMC utilizando su proceso de 3 nanómetros, uno de los más avanzados actualmente en producción comercial. Cada unidad integra más de 140.000 millones de transistores, una cifra que refleja el salto de complejidad y potencia necesario para ejecutar modelos de gran escala.

Microsoft destacó que el diseño del chip está optimizado para cargas de trabajo de IA a gran escala, priorizando no solo el rendimiento bruto, sino también la eficiencia por dólar, un factor clave para clientes empresariales y desarrolladores que operan modelos intensivos en computación.

Inferencia: el verdadero cuello de botella de la IA

Aunque el entrenamiento de modelos suele acaparar titulares, la inferencia se ha convertido en el verdadero cuello de botella del negocio de la IA. Ejecutar millones de consultas diarias —como las que generan asistentes virtuales, herramientas corporativas o motores de búsqueda— requiere una infraestructura extremadamente eficiente.

Con Maia 200, Microsoft busca reducir la dependencia de hardware externo y optimizar costes operativos en Azure, mejorando márgenes y ofreciendo precios más competitivos a sus clientes. Este enfoque es especialmente relevante en un momento en el que los costes energéticos y de infraestructura están bajo creciente escrutinio.

Integración directa con Azure y Copilot

El nuevo acelerador dará soporte a una amplia gama de servicios de IA dentro del ecosistema de Microsoft. Entre ellos destacan Microsoft 365 Copilot, una de las principales apuestas de la compañía para integrar IA generativa en aplicaciones como Word, Excel o Outlook, así como modelos desarrollados en colaboración con OpenAI.

La integración vertical entre hardware, software y servicios en la nube permite a Microsoft optimizar el rendimiento extremo a extremo, algo que consideran clave para escalar la adopción de la IA en entornos empresariales con altos requisitos de seguridad y fiabilidad.

Despliegue inicial en centros de datos de EE. UU.

Microsoft confirmó que Maia 200 comenzará a desplegarse inicialmente en centros de datos del centro de Estados Unidos, con planes de expansión a otras regiones en fases posteriores. Este enfoque gradual permitirá a la compañía validar el rendimiento del chip en entornos reales antes de una implementación global.

El despliegue interno también refuerza el control de Microsoft sobre su infraestructura crítica, en un contexto de creciente presión sobre la cadena de suministro de semiconductores avanzados.

Competencia directa con Nvidia y otros gigantes

El lanzamiento de Maia 200 refuerza la estrategia de Microsoft de desarrollar chips propios, siguiendo una senda similar a la de Google con sus TPUs o Amazon con los procesadores Trainium e Inferentia. Aunque Nvidia sigue dominando el mercado de aceleradores de IA, los grandes proveedores de nube buscan reducir su dependencia de un único suministrador.

Este movimiento no implica una ruptura inmediata con Nvidia, sino una diversificación estratégica que otorga mayor flexibilidad, poder de negociación y control tecnológico a largo plazo.

Impacto económico y estratégico

Desde el punto de vista económico, el desarrollo de chips propios permite a Microsoft reducir costes estructurales, mejorar la previsibilidad del gasto en infraestructura y ofrecer servicios de IA más escalables. A largo plazo, esta estrategia puede traducirse en ventajas competitivas significativas frente a otros proveedores de nube.

Además, el control del hardware refuerza la posición de Microsoft como socio tecnológico de grandes empresas y gobiernos, en un momento en el que la soberanía digital y la seguridad de los datos son prioridades crecientes.

La IA como pilar del crecimiento futuro

Microsoft ha dejado claro que la inteligencia artificial es uno de los ejes centrales de su estrategia de crecimiento. Inversiones multimillonarias, alianzas con OpenAI y ahora el desarrollo de chips propios forman parte de un plan a largo plazo para liderar la próxima fase de la transformación digital.

El lanzamiento de Maia 200 no es solo una innovación técnica, sino una declaración estratégica: la compañía quiere controlar todos los eslabones de la cadena de valor de la IA, desde el silicio hasta las aplicaciones finales.

Un paso más en la guerra del silicio

Con Maia 200, Microsoft se suma de lleno a la guerra del silicio, una batalla que definirá el liderazgo tecnológico de la próxima década. La capacidad de ofrecer IA potente, eficiente y rentable será determinante para atraer clientes y consolidar posiciones en un mercado cada vez más competitivo.

A falta de conocer métricas comparativas detalladas, el movimiento deja claro que Microsoft no está dispuesta a quedarse atrás en la carrera por la infraestructura que alimenta la revolución de la inteligencia artificial.